最新的神奇变脸工具StarGAN第二版来了!这次不仅可以人变人,还能实现猫、狗、虎、豹各种动物无缝切换,输入图片给进去,想变什么自己挑!数据集和Github资源已开放。戳右边链接上新智元小程序了解更多!

猫变狗、狗变虎、虎变豹,男人变女人,无缝切换是个什么神奇体验?

最近,一家名为ClovaResearch的机构的研究团队就像让用户体验一把这种神奇,他们提出的StarGANv2图像转换模型能够实现这一点。

StarGANv2:青出于蓝,同时解决多样性和扩展性

优秀的图像-图像转换模型需要学习不同视觉域之间的映射,要同时满足以下属性:1)生成图像的多样性和2)在多个域上的可扩展性。现有方法一般只能解决这两个问题的其中一个,即要么对于所有域,其呈现的多样性有限,要么需要使用多个模型。

StarGANv2可以同时解决这两个问题,在CelebAHQ面部和新的动物面部数据集(AFHQ)上进行的实验表明,StarGANv2在图像质量、多样性和可扩展性方面较基线标准和过去的模型均实现了提升。为了更好地评估模型,还发布了AFHQ数据集,该数据集具有较大域间和域内差异的高质量动物面部图像。

考虑到每个图像域中的不同样式,理想的图像-图像转换应该能够合成图像。但是,设计和学习此类模型是很复杂的,因为数据集中可能涵盖大量图像模式和领域。

Github资源地址:

https://github.com/clovaai/stargan-v2

为了解决图片样式的多样性问题,过去的新方法向生成器加入了低维潜代码,从标准的高斯分布中随机采样。但是,由于这些方法仅考虑了两个域之间的映射,因此无法扩展到越来越多的域。例如,具有N个域,这些方法需要训练N(N-1)个生成器来处理每个域之间的转换,从而限制了它们的实际使用。

为了解决可扩展性问题,有研究提出了统一的框架。StarGAN是最早的模型之一,它使用一个生成器来学习所有可用域之间的映射。生成器将域标签作为附加输入,并学习将图像转换为相应的域。但是,StarGAN仍然需要学习每个域的确定性映射,这可能无法获取数据分布的多模式性质。在给定源图像的情况下,它不可避免地在每个域中产生相同的输出。

StarGANv2可以同时解决这两方面的问题,可以跨多个域生成不同的图像。该方法以StarGAN为基础,用特定域的样式代码替换原来的域标签,这些代码可以表示特定域的各种形式。StarGANv2引入两个模块,一个映射网络和一个样式编码器。前者学习将随机高斯噪声转换为样式代码,后者学习从给定的参考图像中提取样式代码。

最后,利用这些样式代码,生成器会成功地在多个域上学习合成各种图像(图1)。StarGANv2确实受益于新的样式代码的使用。与目前的SOTA方法相比,我们的方法可扩展到多个域,并且在视觉质量和多样性方面生成了性能更好的结果。

研究人员还提出了质量更高、变化范围更宽的动物面孔(AFHQ)新数据集,更好地评估域间和域内差异较大的图像-图像翻译模型的性能,并公布了数据集。

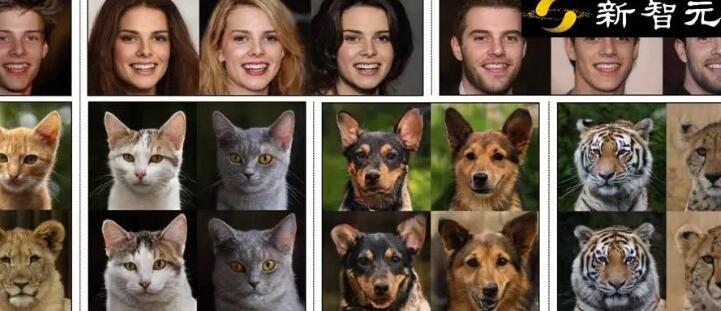

CelebA-HQ数据集和新收集的动物脸部(AFHQ)数据集上的各种图像合成结果。第一列显示输入图像,其余列是StarGANv2合成的图像。

StarGANv2由四个模块组成。(a)生成器将输入图像转换为反映域特定样式代码的输出图像。(b)映射网络将潜在代码转换为多个域的样式代码,其中一个是在训练期间随机选择的。(c)样式编码器提取图像的样式代码,允许生成器执行参考引导的图像合成。(d)判别器从多个域中区分真实图像和虚假图像。

CelebA-HQ数据集上各种配置的性能。Frechet初始距离(FID)表示真实图像和生成图像的两个分布之间的距离(越低越好),而学习到的感知图像斑块相似度(LPIPS)代表生成图像的多样性(越高越好)。

使用表1中的每种配置生成的图像的视觉比较。请注意,给定源图像,配置(A)-(C)提供单个输出,而(D)-(F)生成多个输出图像

潜在指导合成图片的定量比较。真实图像的FID由训练集和测试集之间计算。注意,由于测试图像的数量不足,它们可能不是最佳值。

CelebA-HQ和AFHQ数据集上潜指导图像合成结果的定性比较。每种方法都使用随机采样的潜在代码将源图像(最左侧列)转换为目标域。(a)前三行对应于后三行中将男性转换为女性,反之亦然。(b)从顶部开始的每两行按以下顺序显示合成图像:猫-狗,狗-野生动物、野生动物-猫。

目前作者只是在上面发布了论文的链接,还没有给出StarGANv2的实现代码,手痒的小伙伴可以先来回顾一下用TensorFlow实现StarGAN代码,只需要1天时间即可训练完。