多模态大模型家族,又有新成员了!

不仅能将多张图像与文本结合分析,还能处理视频中的时空关系。

这款免费开源的模型,在MMbench和MME榜单同时登顶,目前浮动排名也保持在前三位。

这款多模态大模型名叫MMICL,由北京交通大学、北京大学、UCLA、足智多模公司等机构联合推出。

MMICL一共有两个基于不同LLM的版本,分别基于Vicuna和FlanT5XL两种核心模型。

这两个版本都已经开源,其中,FlanT5XL版可以商用,Vicuna版本只能用于科研用途。

在MME的多项任务测试中,FlanT5XL版MMICL的成绩已连续数周保持着领先地位。

其中认知方面取得了428.93的总成绩(满分800),位列第一,大幅超过了其他模型。

感知方面的总分1381.78(满分2000),在最新版榜单中仅次于阿里的千问-7B和昆仑万维的天工模型。

所需配置方面,官方给出的说法是在训练阶段需要6块A40,推理阶段则可以在一块A40上运行。

仅仅只需要从开源数据集中构建的0.5M的数据即可完成第二阶段的训练,耗时仅需几十小时。

那么,这个多模态大模型都有哪些特色呢?

01

会看视频,还能“现学现卖”

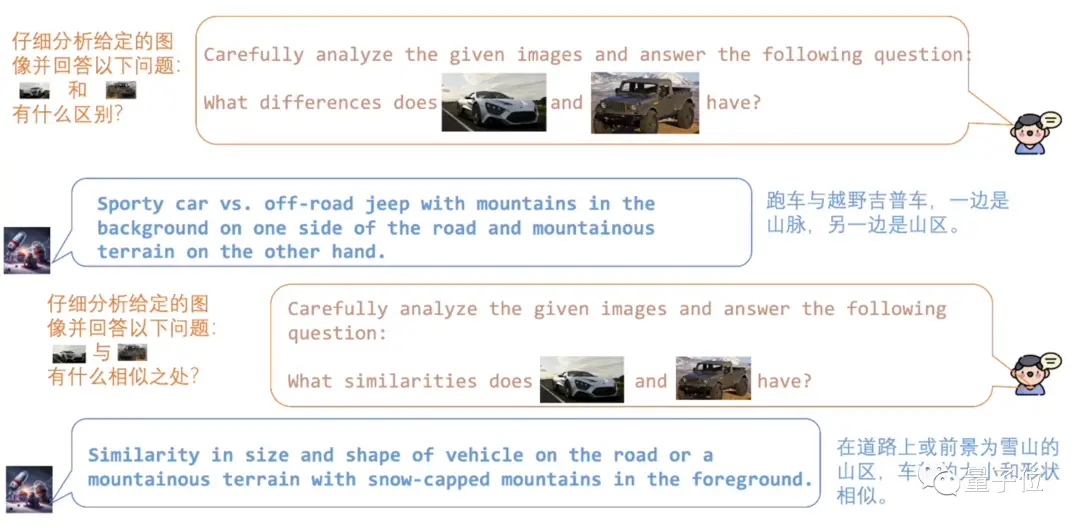

MMICL支持文本和图片穿插形式的prompt,用起来就像微信聊天一样自然。

用正常说话的方式把两张图喂给MMICL,就可以分析出它们的相似和不同之处。

除了超强的图像分析能力,MMICL还知道“现学现卖”。

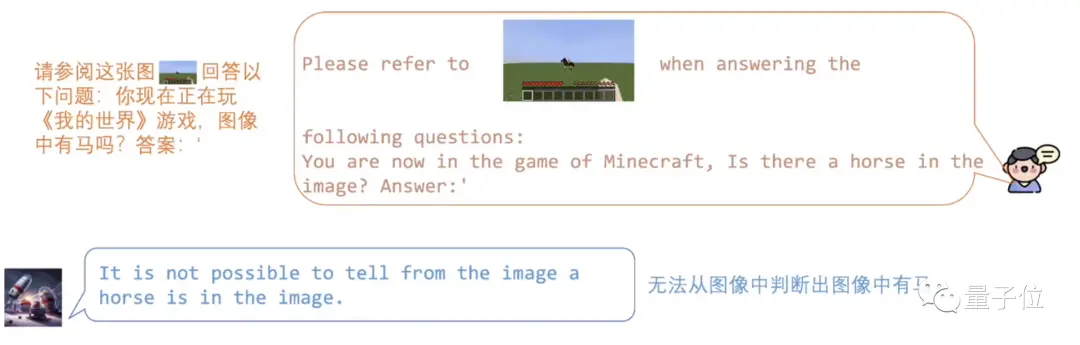

比如我们丢给MMICL一张“我的世界”中像素风格的马。

由于训练数据都是真实世界的场景,这种过于抽象的像素风MMICL并不认识。

但我们只要让MMICL学习几个例子,它便能很快地进行类比推理。